Elon Musk hat nun die Veröffentlichung des Chatbots „Grok“ angekündigt und es scheint tatsächlich so schlimm zu werden, wie ich es mir dachte. In meiner Studie zu Large Language Models hatte ich in einem extra angehängten Epilog genau dieses Szenario antizipiert. Aus aktuellem Anlass veröffentliche ich diesen Abschnitt nochmal gesondert.

Epilog

Die öffentliche Debatte um Künstliche Intelligenz geht sehr häufig um spekulative Szenarien rund um AGI, Superintelligenzen und die Frage, ob diese uns nun retten oder ausrotten werden. Doch LLMs müssen nicht superintelligent sein – eigentlich müssen sie überhaupt nicht in einem menschlichen Sinne intelligent sein –, um einen enormen Einfluss auf alle Aspekte unserer Welt zu haben.

Wenn eine Technologie so tief in unser kollektives Betriebssystem – die Sprache – implementiert wird, sind die Effekte vorhersehbar groß und unvorhersehbar vielfältig. Paul Virilio hat einmal gesagt, dass jede Technologie ihren eigenen Unfall produziert (Virilio/Lotringer 1983, S. 35 f.). Zwei Dinge sind dabei zu ergänzen: Ein Unfall ist nur dann ein Unfall, wenn er nicht vorhergesehen wurde. Und die Gefährlichkeit des Unfalls ist proportional zur Mächtigkeit des verunfallenden Systems. Denken wir an Social Media. Die Euphorie aus den Anfangstagen war im Nu verflogen, als wir feststellten, dass Plattformen als politische Waffen missbraucht werden können. Etwas sehr Ähnliches ist auch für LLMs zu erwarten.

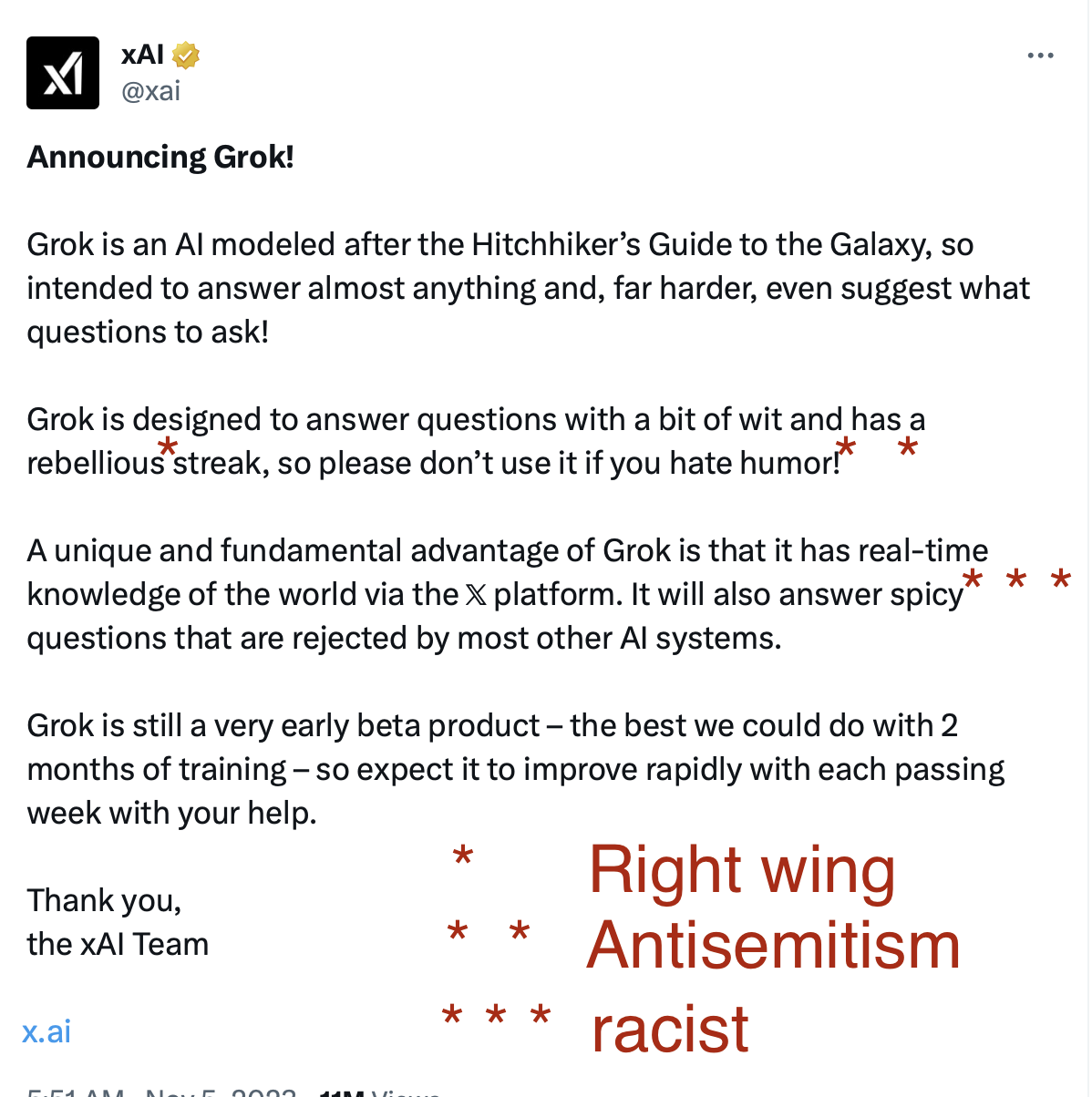

Während diese Studie verfasst wurde, hat sich Elon Musk ausführlich über sein eigenes, geplantes LLM-Projekt namens xAI geäußert (Kerner 2023). Ob es jemals Realität wird, muss wie jede Ankündigung von Elon Musk in Zweifel gezogen werden (Molloy 2023). Dennoch lohnt es sich, die Rhetorik seiner Ankündigungen genauer zu betrachten. Musk spricht z.B. davon, dass sein LLM vor allem der „Wahrheit“ verpflichtet sein werde. Das hört sich erstmal gut an, denn die Wahrheit ist uns schließlich allen wichtig.

Nach allem, was wir in dieser Studie über LLMs gelernt haben, sollte uns diese Ankündigung aber auch sofort misstrauisch machen. LLMs sind strukturell nicht in der Lage, zwischen Wahrheit und Fiktion zu unterscheiden. Sie produzieren immer nur richtig ausschauende Antworten, die zwar häufig wahr sein können, aber nicht müssen. Auch wenn es wahrscheinlich Möglichkeiten gibt, dieses „Halluzinieren“ zu vermindern, ist der Anspruch eine „Wahrheits“-KI bauen zu wollen, ein enorm gefährlicher.

Schaut man weiter im Text, wird auch klar, was Musk genau meint. Seiner Ansicht nach müsse ein LLM von jeder „political correctness“ befreit werden, damit es fähig sei, auch „kontroverse Wahrheiten“ auszusprechen. Man muss das gar nicht in den Kontext seiner vielen rassistischen, sexistischen, transund homophoben und antisemitischen Äußerungen der letzten Jahre betrachten, um zu verstehen, was er damit sagen will. Es reicht, sich anzuschauen, wie er Twitter (mittlerweile „X“) führt und warum er es überhaupt gekauft hat. Twitter, die öffentlichste Bühne unter den Internetplattformen, ist für Musk vor allem eine wichtigste Waffe im Kulturkampf geworden (Seemann 2023). xAI, wenn es je das Licht der Welt erblickt, soll einen sehr ähnlichen Zweck erfüllen.

Das Problem ist, dass sein Wunsch einer politisch unkorrekten KI sehr einfach zu erfüllen ist. Tatsächlich muss man viel Arbeit im Fine-Tuning aufwenden, um einem LLM zumindest die schlimmsten rassistischen Ausfälle halbwegs zuverlässig abzutrainieren. Spart man sich diese Arbeit, bekommt man sozusagen eine rassistische, sexistische und homophobe KI ab Werk.

Dafür gibt es ein bekanntes Beispiel. 2016 veröffentlichte Microsoft einen experimentellen Chatbot namens Tay, den es über die API mit Twitternutzer\*innen interagieren ließ. Tay war so konfiguriert, dass es direkt aus den Konversationen mit anderen lernen konnte. Ein Teil der Nutzerschaft auf Twitter nutzte die Gelegenheit, Tay in allerlei Diskussionen über Rasse und Neonazismus zu verwickeln, bis Tay fast nur noch antisemitische, sexistische und rassistische Dinge ausspuckte (Vincent 2016).

Tay galt als eines der schlimmsten PR-Desaster in der jüngeren Microsoft-Geschichte und wurde als warnendes Beispiel verstanden. Elon Musk sieht darin wohl eher ein weiteres Beispiel der Cancel Culture und will mit xAI diese Leerstelle wieder füllen. Wenn seine KI dereinst schwarze Menschen beleidigt oder von der jüdischen Weltverschwörung redet, wird er das nicht als Fehler betrachten, sondern als „die Wahrheit“ deklarieren. Seine große Gefolgschaft an jungen, weißen Männern wird auch diesmal applaudieren.

Noch einmal: Es ist nicht abzusehen, ob das Projekt überhaupt veröffentlicht wird oder ob es so kommen wird wie oben beschrieben. Doch Musks Plan weist auf eine Gefahr hin, die noch zu wenig thematisiert wird: Es ist nicht nur so, dass LLMs die Biases der Menschen übernehmen oder problematische Denkfiguren reproduzieren. Manche Menschen könnten das genauso wollen.

Dass mit Sprache Politik gemacht wird, ist keine Neuigkeit. Jede Verwendung von Sprache ist zumindest auch politisch, reproduziert sie doch unwillkürlich all die Muster, Narrative und Figuren, auf die wir in der Kommunikation unbewusst zurückgreifen. So definiert z.B. jeder Sprachakt immer auch mit, wo die Grenze zwischen dem verläuft, was eine normale, legitime Äußerung ist, und was nicht (vgl. Mackinac Center for Public Policy 2023).

Ein LLM, zumindest wenn es von vielen Menschen im Alltag verwendet wird, ist eine Teilautomatisierung von Aussagen. Es produziert Sprachakte am Fließband, die von Menschen oft ohne viel Reflexion übernommen und weiterverbreitet werden. LLMs können darüber hinaus ganz automatisiert die Kommunikationswege befüllen und tun das bereits. Wenn jemand Interesse daran hat, eine bestimmte Sprachfigur zu etablieren oder eine bestimmte Rhetorik zu normalisieren, dann wäre die Kontrolle über ein populäres LLM enorm praktisch.

So könnte eine mögliche Zukunft von LLMs aussehen: Politisch segregiert nutzen wir das eine, aber nicht das andere LLM, nicht nur um unsere Kommunikation und unsere Arbeitsund Denkprozesse zu beschleunigen, sondern auch um unsere Sicht auf die Welt auszudrücken. Wenden Sie sich deswegen einfach an den einen oder an den anderen Tech-Konzern ihres Vertrauens.

Schaut man sich Phänomene wie QAnon an, ist es sogar leicht vorstellbar, dass sich um bestimmte LLMs ganze politische Bewegungen, vielleicht sogar sektenartige Anhänger\*innen versammeln, die in dem Output der Maschine die Offenbarung einer höheren spirituellen Wahrheit wähnen. Dafür müssten sich LLMs technisch gar nicht weiter entwickeln. Im Gegenteil, ein zu kohärenter Output wäre hier sowieso nur hinderlich. Oder es könnte ganz anders kommen, und es formiert sich eine gesellschaftliche Gegenmacht, die grundlegende Neuausrichtung unserer gesellschaftlichen Kommunikationsstruktur durch einige wenige Internetkonzerne nicht hinzunehmen bereit ist. Es könnte sich ein breiter Widerstand formen, der versucht, über öffentliche Proteste und politische Einflussnahme die Weiterentwicklung von solchen oder ähnlichen KISystemen zu stoppen. Prominente, Politiker\*innen und Institutionen könnten sich selbst verpflichten, diese Systeme zu boykottieren. Es könnten Verbote von KI in bestimmten Bereichen der menschlichen Kommunikation erlassen werden (Geuter 2023); es könnte vielleicht die Technologie selbst verboten und international geächtet werden (Reijers/Maschewski/Nosthoff 2023).

Auch dieses Szenario ist absolut vorstellbar, wenn man bedenkt, dass im Vergleich zu den bisherigen Automatisierungswellen diese Welle eine wirtschaftlich gut aufgestellte, medial kompetente und sozial gut vernetzte Gruppe bedroht.

Auch über die Frage der Arbeitswelt hinaus ist das Thema Large Language Model ein politisches Thema. Es ist ein Missstand, dass es nach wie vor unter vornehmlich technischen Gesichtspunkten verhandelt wird.

2 Kommentare zu xAi / Grok