/*****

Für die Zeitschrift der Bundeszentrale für politische Bildung „Zu Politik und Zeitgeschichte“ (APuZ) habe ich meinen Vortrag über den digitalen Kapitalismus vom vom letzten Herbst verschriftlicht. Aus Platzmangel wurde er rund um die Hälfte zusammengekürzt, auch wenn die Grundaussage gut erhalten blieb. Dennoch erlaube ich mir hier nun die Directors Cut Version zu posten, für alle, die gerne noch ein paar mehr Argumente hören möchten, warum der digitale Kapitalismus vielleicht not so much ein Kapitalismus ist. Die APuZ kann man hier runterladen oder bestellen.

*****/

[PDF Download]

Ein Gespenst geht um in Europa, es ist das Gespenst des digitalen Kapitalismus. Und wie es sich im konsumgeilen Kapitalismus ziemt, kommt er in vielen Formen und Farben: Informationskapitalismus, Daten-Kapitalismus, Plattform-Kapitalismus, Surveillance Capitalism und kognitiver Kapitalismus. Der digitalen Kapitalismen gibt es mittlerweile so viele, dass man sich wie bei Rossmann vor dem Shampoo-Regal fühlt.

Ich habe mir einen Großteil der Literatur angeschaut und ich habe Fragen. Genauer gesagt habe ich fünf beunruhigende Fragen an den Kapitalismus.

Mit „beunruhigend“ meine ich im übrigen nicht dieselbe Unruhe, in die sich die Autor/innen der unterschiedlichen Digital-Kapitalismus-Beschreibungen hineinsteigern. Es geht mir nicht darum, zu zeigen wie nun diese neue, die digitale Spielart des Kapitalismus schlimmer ist als alle vorhergehenden. Meine Beunruhigung gilt vielmehr dem Kapitalismus selbst. Ich lege ihm gewisser Weise meine Hand auf die Schulter und frage leise: „Alles OK mit dir, Kapitalismus“?

Denn während die meisten Autor/innen in der Digitalversion des Kapitalismus eine weitere Radikalisierung des Kapitalismus ausmachen, habe ich eher das gegenteilige Gefühl. Ich glaube, dem Kapitalismus geht es nicht gut im Digitalen. Ich will deswegen grundsätzlicher fragen, ob der Kapitalismus in seiner digitalen Spielweise wirklich noch die Kriterien erfüllt, mit denen wir dieses System des Wirtschaftens und der Organisation der Gesellschaft beschreiben.

Ich habe mir also verschiedene Kapitalismus-Definitionen angeschaut und versucht den Kern daraus zu extrahieren. Darunter war natürlich Marx’ einflussreiche Analyse des Kapitalismus, aber auch die Definition in der Wikipedia, als auch des Gabler Wirtschaftslexikons, sowie weitere aus spezifischen Sachbüchern. Diese Definitionen weichen hier und da von einander ab aber haben dann doch einen kleinsten gemeinsamen Nenner, eine Art übereinstimmenden Kern, weswegen es mir gelang, die fünf wichtigsten Kriterien herauszuziehen, von denen ich glaube, dass sie als allgemein Zustimmungsfähig gelten können:

Kapitalismus erfüllt folgende fünf Kriterien:

- Privateigentum an den Produktionsmitteln (Namensgebend: Kapital)

- Der Widerspruch zwischen Kapital und Arbeit (Zumindest bei Marx)

- Die Steuerung der Wirtschaft durch den Markt (Neoklassische Definition)

- Das Vorherrschen einer Eigentumsordnung (Heinsohn/Steiger)

- Das Prinzip der Akkumulation. (oder auch: Wachstum)

- Fazit

Ich möchte mir also im Folgenden genauer anschauen, wie diese fünf Kriterien auf den digitalisierten Kapitalismus passen.

Das Kapital

Fangen wir mit dem Offensichtlichsten – dem Privateigentum an den Produktionsmitteln, dem “Kapital” – an. Wir bewegen uns hier sofort in marxistischer Terminologie, aber auch in den übrigen Wirtschaftswissenschaften dürfte unstrittig sein, dass dies einer der wesentlichen Grundpfeiler des Kapitalismus ist.

Doch hat sich gerade hier durch die Digitalisierung viel getan. Zu Marx’ Zeiten waren die Produktionsmittel in erster Linie Land, Gebäude, Maschinen und vielleicht noch Fahrzeuge. Um sich zu veranschaulichen, wie krass sich die Essenz des Kapitals durch die Digitalisierung geändert hat, braucht man sich nur folgende, mittlerweile sprichwörtliche Aufzählung, vor Augen zu führen:

- Uber, das größte Taxiunternehmen der Welt, besitzt keine Fahrzeuge.

- Alibaba, der wertvollste Einzelhändler der Welt, hat kein eigenes Inventar.

- Airbnb, der weltweit größte Übernachtungs-Dienstleister besitzt keine Immobilien.

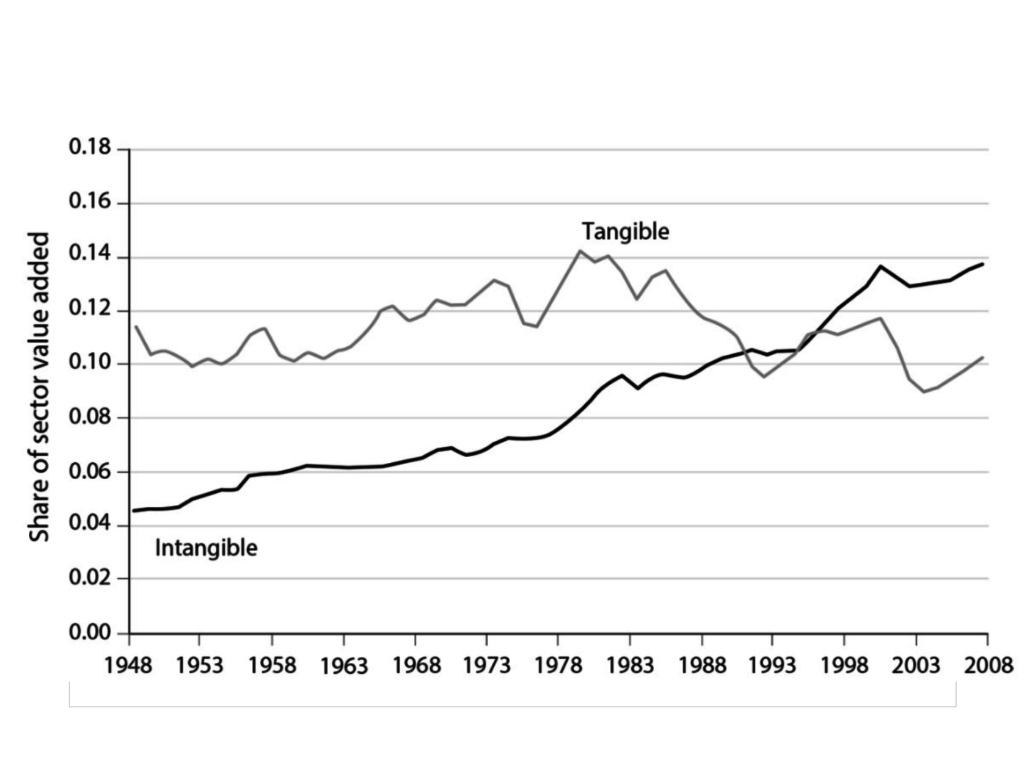

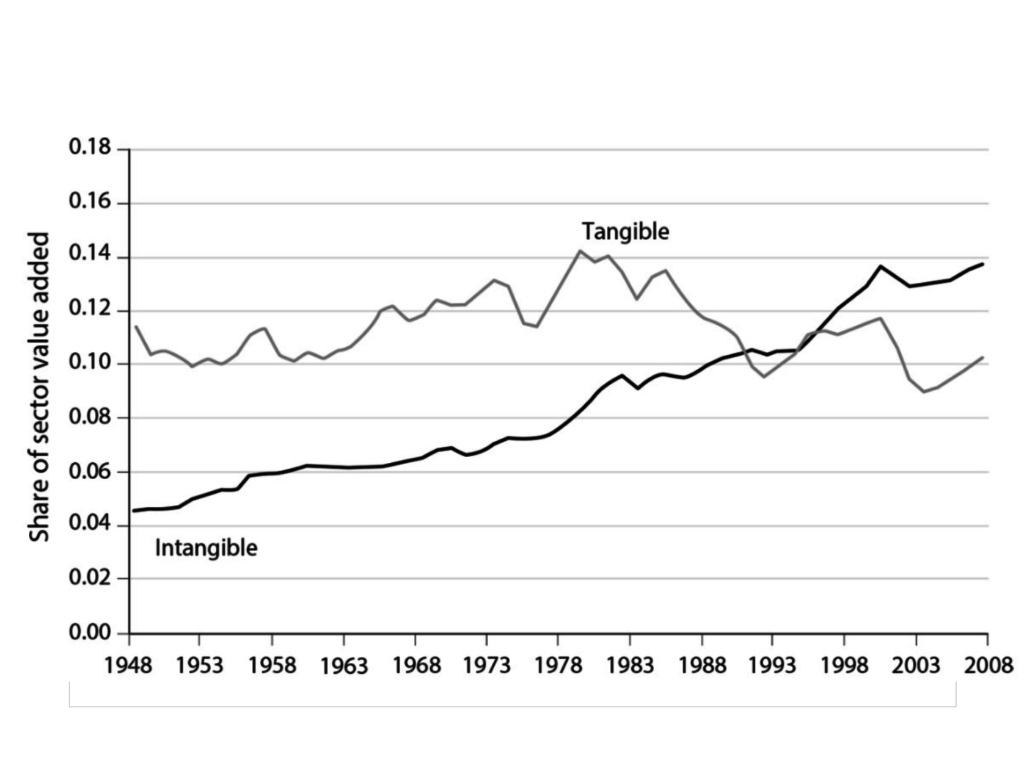

Das klingt erstaunlich, aber doch nach anekdotischer Evidenz. Systematischer haben diesen Zusammenhang Jonathan Haskel und Stian Westlake in ihrem Buch „Capitalism without Capital“ untersucht. Der Untertitel – „The Rise of the Intangible Economy“ – zeigt auch schon an, dass natürlich das Kapital nicht wirklich verschwunden ist. Es hat sich nur dematerialisiert. Zu den materiellen Investitionsgütern die bereits Marx kannte, traten irgendwann Software, Datenbanken, Design, Marken, Fortbildungen und sonstige nicht-anfassbare, immaterielle Werte hinzu.

Und sie kamen nicht nur hinzu. In den USA, Großbritannien und Schweden hat der Anteil an immateriellen Investitionen die in materiellen Werte längst überflügelt. Bei den „Standard & Poors“ Top 500 Unternehmen nach Marktwert sind bereits 84% der Werte immateriell.

ABB. 1 Aus Capitalism without Capital

ABB. 1 Aus Capitalism without Capital

Und die Digitalbranche ist hier Vorreiter und Treiber der Entwicklung. Die Tech-Unternehmen führen die Liste der Unternehmen mit den meisten “Intangible Assets” bis zum Platz 8 an, mit Amazon an der Spitze ($827 Mrd., 96% iA) gefolgt von Microsoft ($ 686 Mrd., 95 % iA).

„Nagut, materiell, immateriell, was macht das für einen Unterschied?“ kann man jetzt fragen. Es sind genau vier systemische Unterschiede, die Westlake und Haskel herausarbeiten.

Immaterielle Investitionen …

- sind “versunkene Kosten” (sunk cost). Man kann einmal in immaterielle Werte investiertes Kapital oft schlecht weiterveräußern.

- schwappen über (spill over). Man kann Informationen – und das sind immaterielle Güter immer – schlecht für sich allein behalten.

- skalieren (scalable). Einmal hergestellt kann ein immaterielles Gut unbegrenzt und ohne Zusatzkosten überall eingesetzt werden.

- sind synergetisch (synergy). Immaterielle Güter ergeben oft erst in der Kombination mit anderen immateriellen Gütern neue Produkte, bzw. führen immer wieder zu neuen Anwendungsfällen.

Zusammengenommen hinterlassen diese Unterschiede und damit einhergehende Effekte wiederum riesige Furchen im Kapitalismus selbst. Die beiden Autoren zeigen zum Beispiel, wie die Verschiebung hin zu immateriellen Kapital eine Rolle bei der zunehmenden ökonomischen Ungleichheit in der Gesellschaft oder dem vergleichsweise geringen Wirtschaftswachstum spielen.

Am spannendsten ist jedoch der Spill-Over-Effekt. Wir kennen den Effekt überall dort, wo gerade im urheberrechtlich geschützte Werke in Internet getauscht werden. Für industrielle Produzenten kann es aber auch einfach heißen, dass sich der Konkurrent die „Best Practice“ zur Herstellung von einem Produkt abschaut, oder eine von ihm eingesetzte Software nachbaut.

Einige – aber lange nicht alle – immaterielle Investitionen kann man deswegen rechtlich schützen lassen. Und hier kommen wir überhaupt erst wieder ins Fahrwasser unseres Kapitalismus-Kriteriums. Nur immaterielle Investitionen, die man über Urheberrechte, Patente oder Markeneintragung schützen kann, können überhaupt als „Privateigentum“ gelten und tauchen als “Assets” in den Bilanzen auf.

Aber selbst diese Formen von „Privateigentum“, also „Geistigem Eigentum“ sind in ihrer Eigentumsstruktur höchst fragwürdig, die bemessung ihres Wertes ist an der Grenze zur Beliebigkeit. Im Grunde handelt es sich um reine Monopolverwertungsrechte. Es sind also Behauptungen derart: „Der Staat sagt, dass nur ich diese Idee/Information/Marke/Logo nutzen darf.“

Und das führt mich zu meiner ersten beunruhigenden Frage:

„Ist ein digitaler Kapitalismus mit nur noch behaupteten Kapital überhaupt noch Kapitalismus?“

Arbeit

Ein wesentlicher Bestandteil jeglicher Kapitalismus-Definition und insbesondere bei Marx ist die Funktion von Arbeit, bzw. die Gegenüberstellung von Arbeit und Kapital als Teile des Produktionsvorgangs. Der marx’schen These nach ist menschliche Arbeit (genauer: gesellschaftlich notwendige Arbeit) dasjenige, was überhaupt den „Wert“ (als Tauschwert einer Ware innerhalb der Ökonomie) erschafft. Da der Arbeiter aber nicht in der vollen Höhe seiner Wertschöpfung entlohnt wird, sondern nur in etwa in der Höhe, die notwendig ist, um seine Arbeitskraft zu wieder herzustellen (Reproduktion), streicht der Kapitalist diese Differenz (Mehrwert) als Profit ein.

Auch in den herkömmlichen Wirtschaftswissenschaften sind sowohl Arbeit als auch Kapital die wesentlichen Produktivkräfte, jedoch wird dort ein anderer Werttheorie-Ansatz verfolgt. Wir kommen noch dazu.

Doch wenn wir uns zum Beispiel den Einsatz von Arbeit und erzieltem Wert in der Digitalwirtschaft anschauen, springen uns einige Dinge sofort ins Auge. Am besten vielleicht verdeutlicht, wenn wir die amerikanische Videothekskette Blockbuster mit dem Videostreamingdienst Netflix vergleichen.

Netflix machte im Jahr 2018 mit 5400 Mitarbeiter/innen $15,7 Milliarden Dollar Umsatz, während der mittlerweile pleite gegangene Videoverleih-Riese Blockbuster in seinem letzten Jahr (2010) mit 25.000 Mitarbeiter/innen nur 3.24 Milliarden Dollar umsetzte. Das bedeutet, dass Blockbuster mit 5 mal so vielen Mitarbeiter/innen gerade mal 20% des Umsatzes von Netflix machte, obwohl beide in einem ähnlichen Business sind.

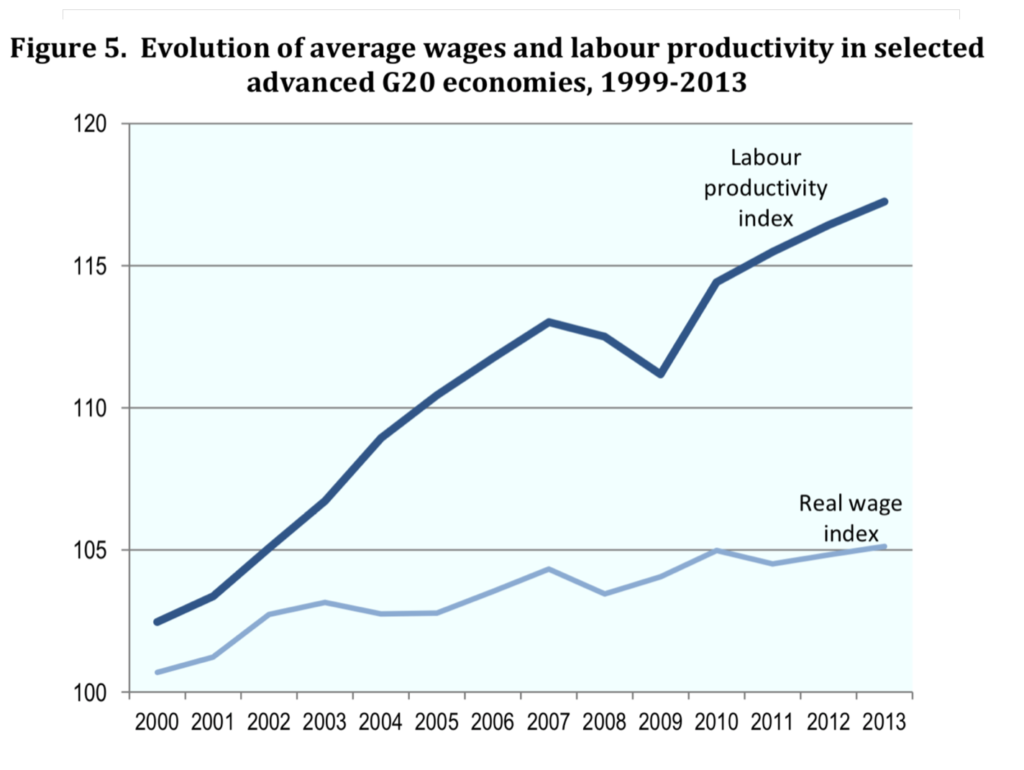

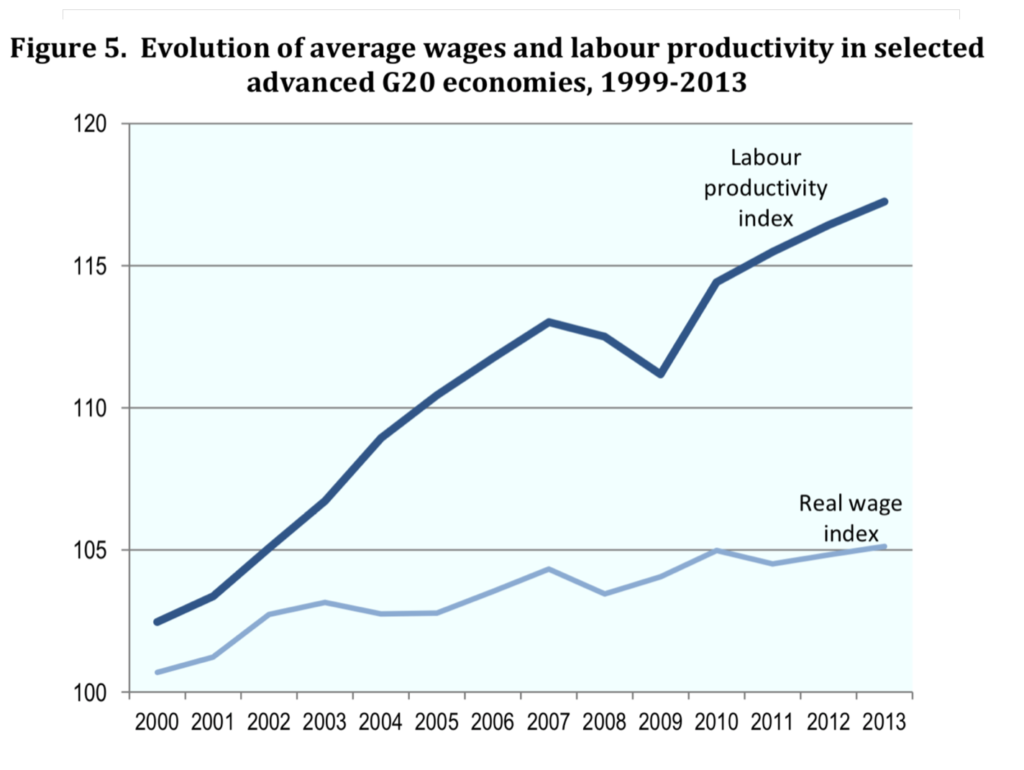

Pro Angestellte/r scheint die Digitalwirtschaft viel mehr Wertschöpfung zu produzieren, als die alte, analoge Wirtschaft. Gemessen wird dieser Zusammenhang in der Wirtschaftswissenschaft als Arbeitsproduktivität und wenn wir die Zahlen für die Gesamtwirtschaft (zum Beispiel für die G20 Staaten) anschauen, sehen wir in der Tat ein enormes Wachstum der Arbeitsproduktivität aber nur ein geringes Wachstum der Löhne.

ABB 2. Aus International Labour Organization Organisation for Economic Co-operation and Development, The Labour Share in G20 Economies

ABB 2. Aus International Labour Organization Organisation for Economic Co-operation and Development, The Labour Share in G20 Economies

Dass diese Differenz bei den Kapitalisten landet ist also folgerichtig und bereits bei Piketty untersucht, der zeigte, wie sich das Wachstum der Anlagevermögen entsprechend von dem Wachstum der Löhne entkoppelt hat. r > g bringt die wachsende Ungleichheit auf den Punkt.

Diese Entwicklung zeigt sich auch in einem weiteren Phänomen, der heutigen Weltwirtschaft: dem stetigen Sinken der Lohnquote. Über viele Jahrzehnte lag der Anteil des Volkseinkommens (Bruttoinlandsprodukt/GDP), der in Form von Löhnen ausgezahlt wurde, sehr stabil bei etwa zwei Drittel. Seit den letzten 30 Jahren scheint sich das zu ändern. In der ganzen Welt sinkt die Lohnquote. In den USA um 6%, in Deutschland 7%, in Frankreich sogar um 14%. Es gibt verschiedene Erklärungsmuster, bei denen meist Globalisierung und Automatisierung im Mittelpunkt stehen. In ihrer Studie „The Fall of Labor Share and the Rise of Superstar Firms“ machen die Autor/innen einen anderen Grund aus: Superstar Firms. Konkret: Die Wirtschaft hat sich immer mehr konzentriert und wird in immer mehr Branchen von übermächtigen Playern dominiert. Diese sind enorm wirtschaftlich, verbuchen ein Großteil der Innovationen und nehmen den Wettbewerbern die Luft zum Atmen. Vor allem erwirtschaften sie mit erstaunlich wenigen Mitarbeiter/innen enorme Umsätze.

Ein großteil dieser Superstar Firms sind natürlich wiederum unsere Tech-Giganten. Unter den arbeitsproduktivsten Firmen der Welt, finden wir viele IT-Konzerne. Apple macht fast zwei Millionen Dollar Umsatz pro Mitarbeiter. Im Durchschnitt. Auch Facebook und Google verdienen auf Platz zwei und drei weit mehr als eine Millionen Dollar pro Mitarbeiter. Aber alle diese Firmen sind nicht dafür bekannt, dass sie ihre Mitarbeiter/innen schlecht bezahlen – im Gegenteil. In Bezug auf Marktpreise verdienen vor allem die Entwickler/innen und IT-Spezialist/innen Löhne weit über dem Durchschnitt. Aber gemessen am erzielten Umsatz verdienen sie nur “Penuts” und aus einer marx’schen Ausbeutungs-Logik heraus betrachtet, sind sie die vielleicht ausgebeutetsten Menschen der Welt, da der extrahierte Mehrwert so enorm ist.

Dabei ist unklar, inwieweit Automatisierung oder gar “Künstliche Intelligenz” bereits in diese Entwicklung mit reinspielt. Die sinkende Lohnquote scheint jedenfalls nicht stark an die Arbeitslosenquote gekoppelt zu sein – derzeit verzeichnen sowohl Deutschland als auch die USA eine historisch geringe Arbeitslosigkeit. Und doch erschienen in den letzten Jahre viele Studien, die einen enormen Jobverlust durch Künstliche Intelligenz prophezeiten: Die Spannen der Prognosen gehen allerdings weit auseinander und nicht alle Experten sind sich darüber Einig, ob wir überhaupt weniger Arbeitsplätze verzeichnen werden. Ein paar einschlägige Beispiele:

2013 warnte die Oxford University in einer vielbeachteten Studie, dass bis zu 47% aller Jobs in den USA bis 2033 in Gefahr seien. 2017 sprach McKinsey von 400 bis 800 Millionen Jobs weltweit bis 2030 und letztes Jahr prognostizierte die OECD gerade noch 9% Jobverlust in ihren Mitgliederstaaten.

Dass wir noch keine Ausläufer dieser Umwälzungen spüren, könnte auch damit zu tun haben, dass die Digitalisierung neue Jobs – allerdings im Niedriglohnsektor – schafft. Man denke an das wachsende unterbezahlte Heer der Paketbot/innen oder an die Essenslieferant/innen und Uberfahrer/innen der digitalen Gig-Economy (die aber mit nur 1% einen überraschend kleineren Anteil haben.). Aber es ist auch nicht überall KI drin, wo KI draufsteht. Oft wird sie nur simuliert oder zumindest flankiert von im Hintergrund arbeitenden Click-Worker/innen in Niedriglohnländern. Der wachsende Anteil Niedriglohnbeschäftigter dürfte als Faktor auch in die sinkende Lohnquote reinspielen.

Doch wenn sich durch Digitalisierung einerseits die Produktivität auf immer weniger Firmen konzentriert, eine unbekannte aber doch vorhandene Menge an Jobs durch Automatisierung wegfällt, dazu immer mehr immer mehr Geringverdienerjobs entstehen, stellt sich die Frage ob das nicht auf Kosten der Mittelschicht-Jobs geht.

Sicher, ein Großteil der Leute arbeitet noch in herkömmlichen, sehr analogen Berufen. Für den Rest könnte David Graebers These von den „Bullshit Jobs“ eine gute Erklärung bieten. Graeber schätzt bis zu 40% der Jobs in der aktuellen Ökonomie seien Jobs, bei denen die Angestellten selbst nicht mehr nachvollziehen können, auf welche Weise er überhaupt produktiv ist. Bullshit-Jobs fehlt meist jeglicher „Sinn“ im gesellschaftlichen Kontext – zumindest wird er so empfunden. In ihrer Studie, „Socially Useless Jobs“ werteten Robert Dur, Max van Lent Umfragen von 100.000 Teilnehmern aus, die aus verschiedenen Zeiträumen und unterschiedlichen Ländern stammen und kommen zu dem Ergebnis, dass es zwar eine Menge der „Bullshit-Jobs“ gibt, sie aber nicht ganz so dominant sind, wie Graeber vermutet. Gerade mal 8% gehen davon aus, dass ihr Job keine gesellschaftlichen Nutzen stiftet. Weitere 17% sind sich des gesellschaftlichen Mehrwerts ihrer Arbeit aber zumindest nicht sicher.

Wie der gefühlte gesellschaftliche Mehrwert mit dem ökonomischen Mehrwert zusammenhängt, ist allerdings nur schwierig bis unmöglich zu messen. Vor allem, da die Art der Wertschöpfung heute ganz und gar anders von statten geht, als Marx es damals beobachtete. Wie hängen also Daten, Arbeit und Wert zusammen? Wo kommt der enorme Reichtum der Tech-Giganten her?

In dem Buch „Das Kapital sind wir“ hat Timo Daum nicht nur eine interessante Beschreibung der digitalen Ökonomie abgeliefert, sondern eine ganz eigene These zur Wertschöpfung im Digitalen aufgestellt. Diese geschehe nicht bei der Produktion von Waren, sondern in Form von Innovation. Und wir alle Arbeiten daran mit, denn wir werden jederzeit vermessen, während wir die digitalen Tools verwenden. Die gesammelten Daten werden dann für die Entwicklung neuer Innovation und Verbesserung der Produkte genutzt. Eine Interessante digitale Variante von Marx’ Arbeitswert-Theorie.

Shoshana Zuboff schlägt in eine ganz ähnliche Kerbe, allerdings klingt bei ihr die Wertschöpfung wesentlich perfider. Auch bei ihr steht die Überwachung der Nutzer/innen im Mittelpunkt, doch statt um Innovation geht es bei ihr um Manipulation. Dabei ist sozusagen das Delta von vorhergesagtem Verhalten zu manipuliertem Verhalten der Punkt, an dem Wert geschöpft wird. Dieser „Verhaltens-Mehrwert“ (behavioral surplus) würde dann als „Surveillance Capital“ abgeschöpft.

In dem Buch „Platform Capitalism“ von Nick Srnicek sind Daten hingegen eine Art Rohstoff, der erst in der Verarbeitung/Verfeinerung (zum Beispiel mittels Big Data) wirklich an Wert gewinnt. Hier wären es die Programmierer der Auswertungsalgorithmen und vor allem Data Scientists, deren Arbeit den Wert schöpft.

Paul Mason kam in seinem Buch „Post-Capitalism“ sogar zum Schluss, dass wenn Information statt Arbeit zum zentralen Bestandteil der Wertschöpfung wird, sich die kapitalistischen Ökonomien nicht werden halten können.

Um ehrlich zu sein, lässt mich die Frage nach Rolle der Arbeit im Digitalen mit vielen unterschiedlichen, einander widersprechenden Theorien und Beobachtungen zurück. Einigkeit scheint allein darüber zu bestehen, dass Arbeit im klassischen Sinn zumindest nicht mehr der wesentliche Ort der Wertschöpfung zu sein scheint.

Ich frage also mit genauso viel Ratlosigkeit wie Beunruhigung:

„Ist ein digitaler Kapitalismus mit nur noch behauptetem Kapital und überflüssiger Arbeit überhaupt noch Kapitalismus?“

Markt

Seit Marx „Das Kapital“ schrieb ist allerdings auch in den Wirtschaftswissenschaften viel passiert. Die heute etablierte Ökonomie hat eine ganz andere Sicht auf den Kapitalismus. Für sie steht nicht der Produktionsprozess im Mittelpunkt des Geschehens, sondern der Markt. Und so findet sich kaum eine zeitgenössische Kapitalismus-Definition, die nicht auch auf den Markt rekurrieren würde. Markt – so die Wirtschaftswissenschaftler – sei das wesentliche Steuerungsinstrument des Kapitalismus. Indem der Markt das Angebot (Produktion) und die Nachfrage (Konsumtion) über das Instrument des Preises im Gleichgewicht hält, sorgt er dafür, dass zu jederzeit immer ungefähr genauso viel von einer Ware produziert wird, wie auch gebraucht wird und sich dieses Angebot auch im Rahmen bezahlbaren bewegt. So jedenfalls die Theorie, die oft und gerne kritisiert wird, da sie eine ganze Reihe von Annahmen voraussetzt, die in der Realität kaum zu erfüllen sind: Völlige Markttransparenz, Menschen als rationale Wirtschaftssubjekte (Homo Oeconomicus), die Nichtexistenz von Transaktionskosten, das Ausblendung von nicht im Markt abgebildeten Einflüssen und Kosten (Externalitäten), etc.

Doch blendet man diese Ungenauigkeiten gutwillig aus, wie das in theoretischen Versuchsanordnung in der Physik ja auch Standard ist, kann man den Markt als „Informationssystem“ verstehen, der als Input die Signale von Anbietern und Nachfragern koordiniert.

Wenn man den Markt als Informationssystem begreift, muss man annehmen, dass er inhärent anschlussfähig an die Digitalsphäre sein sollte. Und Tatsächlich. Es stellt sich heraus, dass sich Marktmechanismen leicht in Algorithmen nachbauen lassen. Genau das hat zum Beispiel Uber mit seinem „Surge Pricing“ gemacht. Je nach Tages- und Nachtzeit sind unterschiedlich viele Uber-Fahrer/innen unterwegs und es gibt unterschiedlich hohe Nachfrage nach Uber-Fahrten. Ubers Surge-Pricing versucht darauf eine Markt-adäquate Antwort zu finden, indem es dem Kunden neben dem Standard-Preis auch noch den Surge-Preis anzeigt. Der Surge-Preis ist im Zweifelsfall höher als der Standard-Preis, aber dafür kommt das Auto sofort. Der Surge-Preis ist also eine Art Marktpreis – mit dem Unterschied, dass er von einem Algorithmus berechnet wurde.

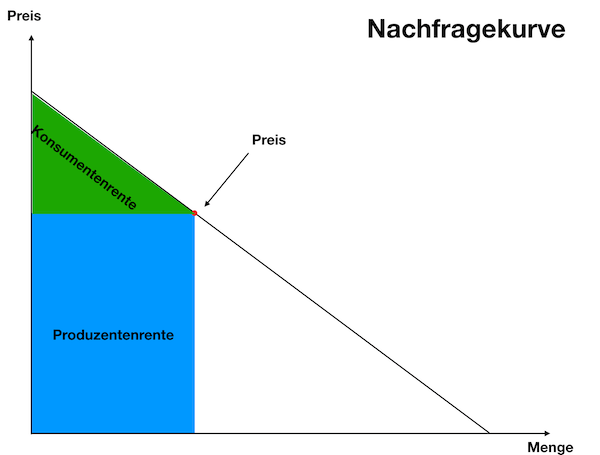

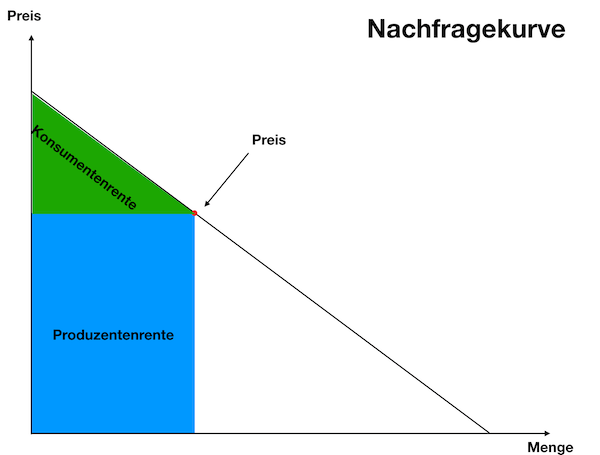

In gewisser Weise führt es die Idee des Marktes ad absurdum, einen Marktmechanismus als datenbankgestützen Algorithmus nachzubauen, bietet aber auch ganz neue Möglichkeiten. So kamen Wirtschaftswissenschaftler um den Ökonom Steven Levitt auf Uber zu und fragten, ob sie denn mal einen Blick in die dabei generierten Daten werfen dürften. In ihrem Paper „Using Big Data to Estimate Consumer Surplus – The Case of Uber“ wurde dann auch etwas revolutionäres gezeigt: nämlich die Nachfragekurve – Beziehungsweise die Konsumentenrente.

Um zu erklären, was es damit auf sich hat, müssen wir kurz zurück zur neoklassischen Vorstellung vom Markt. Während die Angebotskurve eine empirisch vergleichsweise leicht nachzuvollziehende Tatsache ist (man zähle die Hersteller eines Produkts sowie deren Output bei unterschiedlichen Absatzpreisen) war die Nachfragekurve immer nur eine lauwarme Behauptung der Ökonomen. Weder kann man wirklich messen, wieviele Leute bereit wären, ein Produkt zu kaufen, noch, wieviel sie zu welchem Preis bereit wären, davon zu kaufen. Was man machen kann ist, tatsächliche Kunden zählen und alle anderen Leute in Marktforschungsanaylsen zu befragen, aber all das gibt höchstens vage Anhaltspunkte für die Nachfragekurve. Kurz: um die Nachfragekurve zu kennen, müsste man in die Köpfe der Leute schauen.

Mit den Uber-Daten konnten die Wissenschaftler nun genau das tun. In den vielen Millionen Entscheidungen für und gegen den Surge-Preis bei Uber steckt die Nachfragekurve quasi drin – sowie eine ganze Menge andere Erkenntnisse. Beispielsweise sind Leute mit niedrigem Smartphone-Akku in der Regel bereit einen sehr viel höheren Preis für eine sofortige Uber-Fahrt zu bezahlen. Wer hätte das gedacht?

Aber die Beschreibung der Nachfragekurve beinhaltet noch etwas anderes: das, was Ökonomen „Konsumentenrente“ nennen. Die Konsumentenrente ist kurzgesagt die Preisdifferenz zwischen dem Preis, den ich für ein Produkt tatsächlich zahle und dem, den ich zu bezahle bereit wäre, wenn der Preis höher wäre. Diese nichtgezahlte Differenz nehme ich als Konsument sozusagen als Bonus mit. Da jeder Konsument eine unterschiedliche Bereitschaft hat, einen höheren Preis zu zahlen, erhält jeder Konsument somit auch eine individuelle Konsumentenrente. Die allgemeine Konsumentenrente errechnet sich somit, wenn man all diese individuellen Differenzen zusammenrechnet.

ABB 3. Nachfragekurve und Konsumentenrente

ABB 3. Nachfragekurve und Konsumentenrente

Die Untersuchung der Ökonomen ergab, dass Uber im Jahr 2015 eine allgemeine Konsumentenrente in Höhe von 2,9 Milliarden Dollar erwirtschaftet hat. Nochmal: Das ist kein Geld, das irgendwo in irgendeiner Statistik auftaucht. Es ist Geld, dass nicht ausgegeben wurde, aber ausgegeben worden wäre, wenn … ja, das ist eine spannende Frage. Im Grunde, wenn jeder einen personalisierten Preis angezeigt bekommen hätte.

Denn wenn man die Konsumentenrente ausrechnen kann, dann kann man sie auch abschöpfen. Wenn man weiß, dass eine Person mehr Geld zu bezahlen bereit wäre, warum ihm dann nicht auch diesen Preis anzeigen?

So ganz neu ist das allerdings nicht. Die Abschöpfung der Konsumentenrente ist schon lange ein Ziel sehr vieler digitaler Bemühungen. Im öffentlichen Diskurs firmiert das Thema unter „Preisdiskrimierung“. IBM hat dafür extra das Startup „Demand Tech“ gegründet und in Deutschland hat sich „Segment of One“ die Abschöpfung der Konsumentenrente auf die Fahnen geschrieben.

Es ist wichtig sich zu vergegenwärtigen, was hier passiert: Wenn der Marktpreis ein Informationssystem ist und Computer, Internet und Shopsysteme ebenfalls Informationssysteme sind, dann wurde das Erstere durch das Zweitere quasi gehackt. Die IT-Systeme der Anbieter sind einfach intelligenter als der Markt und haben ihn “outgesmarted”.

Das alles hört sich recht dystopisch an, doch kann man den Blick von hier aus auch utopisch wenden: wenn Computersysteme heute intelligenter sind als der Markt, wozu brauchen wir den überhaupt noch? Genau das fragt Stefan Heidenreich in seinem Buch: „Geld Für eine non-monetäre Ökonomie“. Dort stellt er mit einem kühlen, medientheoretischen Blick fest, dass es Geld (und damit Preise und Markt) gar nicht mehr braucht. Stattdessen schlägt er vor, Algorithmen das Angebot mit der Nachfrage matchen zu lassen. Das hat zum einen den Vorteil, dass Menschen durch Akkumulation von Vermögen nicht unfassbar reich werden können, aber auch, dass wir die Machting-Kriterien politisch aushandeln können.

Doch egal, ob Utopie oder Dystopie, wenn Algorithmen den Markt tatsächlich outgesmartet haben, so dass wir über seine Abschaffung diskutieren können, stellt sich die dritte beunruhigende Frage an den digitalen Kapitalismus:

„Ist ein digitaler Kapitalismus mit nur noch behaupteten Kapital und überflüssiger Arbeit, der nicht mehr durch den Markt gesteuert wird, noch Kapitalismus?“

Eigentum

Eine Kapitalismus-Definition, die mir besonders gefällt, da sie schlicht und elegant ist, die sich dabei sowohl von der marxistischen wie auch der neoklassischen Definition absetzt, ohne mit ihnen inkompatibel zu werden, ist diejenige, die Gunnar Heinsohn und Otto Steiger in ihrem Buch: „Eigentum, Zins und Geld“ vorgeschlagen haben. Sie definieren den Kapitalismus schlicht als „Eigentumsordnung“, also eine Gesellschaft die durch das Konzept Eigentum strukturiert ist. Das hört sich zunächst banal, offensichtlich und wenig ertragreich an, wird aber spannend, wenn sie sich die Implikationen des Begriffes „Eigentum“ genauer anschaut.

Während Marx die Ursituation des Kapitalismus in der Produktion verortet und die Neoklassiker dafür den Markttausch heranziehen, sehen Heinsohn und Steiger sie in der Unterscheidung von „Besitz“ und „Eigentum“. Diese Unterscheidung ist selbst keine ökonomische, sondern vor allem eine rechtliche. „Besitz“ ist dabei alles, worüber ich direkte Verfügungsgewalt ausübe. Wenn man mir meinen Besitz nehmen will, muss man ihn mir physisch wegnehmen. Besitzen kann ich daher alles, was ich zu verteidigen imstande bin. Darin unterscheidet es sich vom Eigentum. Ich kann Gegenstände, die mein Eigentum sind, einfach aus der Hand geben, also in den Besitz anderer Menschen geben, ohne dass es aufhört, mein Eigentum zu sein. Das funktioniert, da ich nicht selbst dafür sorgen muss, es wieder zurückzubekommen, sondern der momentane Besitzer verpflichtet ist, es mir zurückzugeben. Eigentum ist ein Rechtstitel, es ist abstrakte Behauptung. Und wenn man genauer hinschaut, merkt man, dass „Eigentum“ nur dann funktionieren kann, wenn eine externe Macht dafür sorgt, dass der Rechtstitel im Zweifelsfall auch durchgesetzt wird. Für Eigentum braucht es also einen Staat mit Gewaltmonopol.

ABB 4. Besitz vs. Eigentum

ABB 4. Besitz vs. Eigentum

Wenn wir uns mit dieser Definition im Kopf wieder dem Digitalen zuwenden, kommt als erstes der Dienst Napster in den Sinn. 1999 gestartet, machte der Dienst schlicht alle Musikdateien auf dem eigenen Computer für alle anderen Napster-User zugänglich. Das Programm hatte eine Suchmaske, mit der man nach jedem beliebigen Song suchen konnte und die daraufhin eine Liste mit Napster-Usern ausspuckte, die ihn besaßen. Ein Klick auf einen der User und der Download startete. Das Prinzip nennt sich Peer-to-Peer (p2p) und wir machten wochenlang nichts anderes mehr; es war das reinste Eldorado.

Die Musikindustrie hatte jedoch Einwände. Für sie war das Eldorado ein „Major Spill-Over“, der totale Kontrollverlust und das plötzliche Ende ihres Geschäftsmodells.

Mit Heinsohn/Steigers Kapitalismus-Definition könnte man sagen, dass die Musikindustrie aus der Eigentumsordnung in eine Download-Besitz-Ordnung zurückfiel. Zwar hat die Musikindustrie (und andere Rechteverwerter) mit viel Lobbyismus dafür gekämpft, das Urheberrecht zu verschärfen und die Rechtsdurchsetzung zu totalisieren, aber trotz allem konnte sie die P2P-Tauschbörsen nicht loswerden. Napster wurde aus dem Netz geklagt, doch nach Napster kam Kazaa, dann eDonkey und schließlich Bittorrent und viele andere Technologien und Kanäle, über die bis heute allerlei Kram getauscht wird.

Hier nun das Spannende: Dass die Musikindustrie heute wieder ein Geschäftsmodell hat, liegt nicht an der Eigentumsordnung, also nicht am Staat, sondern weil eine ganz eigene, neue Ordnung im Internet entstand. Die Ordnung der Plattformen.

Als Apple 2002 auf die Musikverlage zukam und ihnen iTunes zeigte, standen sie gerade mit dem Rücken zur Wand. Sie hatten es nicht geschafft, den P2P-Tauschbörsen ein populäres und legales Angebot im Internet entgegenzustellen. Nun stand Steve Jobs vor ihnen. Er hatte zuvor mit dem iPod den ersten populären, tragbaren MP3-Player auf den Markt gebracht und erzählte ihnen nun von iTunes, einer digitalen Verkaufsplattform für Musik. Die Konditionen, die Jobs ihnen für ihre Rettung diktierte, erzürnten sie jedoch. Musikdateien sollten alle einzeln verkaufbar sein, egal, ob sie teil eines Albums waren oder nicht. Und jeder Song sollte nur 99 Cent kosten.

Jobs konnte den Verlagen die Bedingungen diktieren, weil er etwas hatte, was sie nicht hatten. Und dieses Etwas ist die Grundvoraussetzung für jede Ökonomische Transaktion: Ich nenne es „marktfähige Verfügungsgewalt“. Besitz reicht dafür nicht aus, denn marktfähige Verfügungsgewalt muss es erlauben, eine Sache anzubieten und gleichzeitig vorzuenthalten. Eigentum erschafft diese marktfähige Verfügungsgewalt, denn das Vorenthalten-können wird staatlich garantiert. Marktfähige Verfügungsgewalt wird uns gegenüber überall ausgeübt, am Kiosk, beim Autohändler, im Supermarkt, etc. Im Internet ist marktfähige Verfügungsgewalt jedoch durch die leichte Kopierbarkeit der Daten kaum zu bewerkstelligen und der Staat ist da auch keine Hilfe.

Der Napster-Schock und der Eintritt Apples in das Musikbusiness ist ein historisches Ereignis, das weit über sich selbst hinausreicht. Heute streiten sich Apple, Google und Spotify über die Musikstreaming-Vorherrschaft, aber damals war es Apple, die zeigten wie „marktfähige Verfügungsgewalt“ im Internet funktionieren kann. Plattformen wie iTunes sind in erster Linie Kontroll-Infrastrukturen und sind damit in der Lage Verfügungsgewalt durchzusetzen. Es ist kein Zufall, dass sich Rechteinhaber heute in erster Linie an Plattformen wenden, wenn es darum geht, ihre Rechte durchzusetzen. Vom DMCA-Act in den USA, Youtubes Content-Id an deren Vorbild sich nun die in Europa gesetzlich eingeführten Uploadfilter orientierten – sie alle sollen die Plattformen zu noch effektiveren Instrumenten der Verfügungsgewalt machen, weil der Staat diese nicht mehr garantieren kann.

Doch die marktfähige Verfügungsgewalt der Plattformen sind schon lange nicht mehr auf tatsächliche Rechtstitel beschränkt. Facebook hat keinerlei Eigentumsrechte an unseren persönlichen Daten und dennoch basiert ihr Geschäftsmodell auf der Ausübung einer marktfähige Verfügungsgewalt über sie. Die Plattformen setzen bereits eine Form der Kontrolle durch, die die Eigentumsordnung gar nicht braucht, sondern diese lediglich stellenweise abbildet. Das aber bedeutet nichts Geringeres, als dass das ganze Rechtskonzept des Eigentums und damit die Kapitalistische Ordnung im Sinne von Heinsohn und Steiger im Digitalen obsolet sind.

Was zu der beunruhigenden Frage führt:

„Ist ein digitaler Kapitalismus mit nur noch behaupteten Kapital und überflüssiger Arbeit, der nicht mehr durch den Markt gesteuert wird und die Eigentumsordnung hinter sich gelassen hat, noch Kapitalismus?“

Wachstum

Ein Kriterium kommt bei Kapitalismus-Definitionen sowohl aus der marxistischen, wie auch aus der neoklassischen Schule immer wieder auf und das ist das Wachstum. Bei Marx ist der Kapitalismus auf „Akkumulation“, das heißt ständigem Wertzuwachs ausgelegt. Das ergibt sich einerseits aus der Tatsache, dass der Kapitalist die Bedingungen der Möglichkeit der Produktion jederzeit wiederherstellen (reproduzieren) muss, aber andererseits darüber hinaus auch Profit erwirtschaften will.

Auch in der klassischen Wirtschaftstheorie spielt Wachstum eine zentrale Rolle, sowohl auf der mikroökonomischen Ebene (der Konsument strebt jederzeit danach seinen Nutzen zu maximieren und der Unternehmer will den Gewinn seiner Unternehmung maximieren), als auch auf der makroökonomischen Ebene (die Ökonomie ist auf ständiges Wachstum aus, welches sich im Zins abbildet).

Seit geraumer Zeit haben wir es vor allem in den westlichen Industrienationen auf dieser Ebene mit einem mysteriösen Phänomen zu tun, das Ökonomen die „Säkulare Stagnation“ nennen. Sie nennen sie so, weil das geringe Wachstum seit der Finanzkrise 2007 eigentlich mit herkömmlichen Theorien nicht erklärbar ist. So sind die Leitzinsen der Währungsbanken zwar so niedrig, dass wir bereits seit vielen Jahren einen negativen Realzins (also Zins minus Inflation) haben, doch obwohl Geld noch nie so billig war, bleibt die Sparquote hoch und die Investitionen bleiben spärlich. All das deutet eigentlich auf eine Rezession hin, doch gleichzeitig haben wir es mit einer vergleichsweise niedrigen Arbeitslosenquote zu tun, was bedeutet, dass die Wirtschaft gut ausgelastet ist.

Es gibt eine vielschichtige Diskussion in der Ökonomie über die Ursachen der säkularen Stagnation. Schon Maynard Keynes hat die Möglichkeit vorhergesehen, dass die Sparquote die Investitionsquote übersteigt und auch zu Marx’ These von dem tendenziellen Fall der Profitrate böte sich als Erklärung für unseren Zustand an.

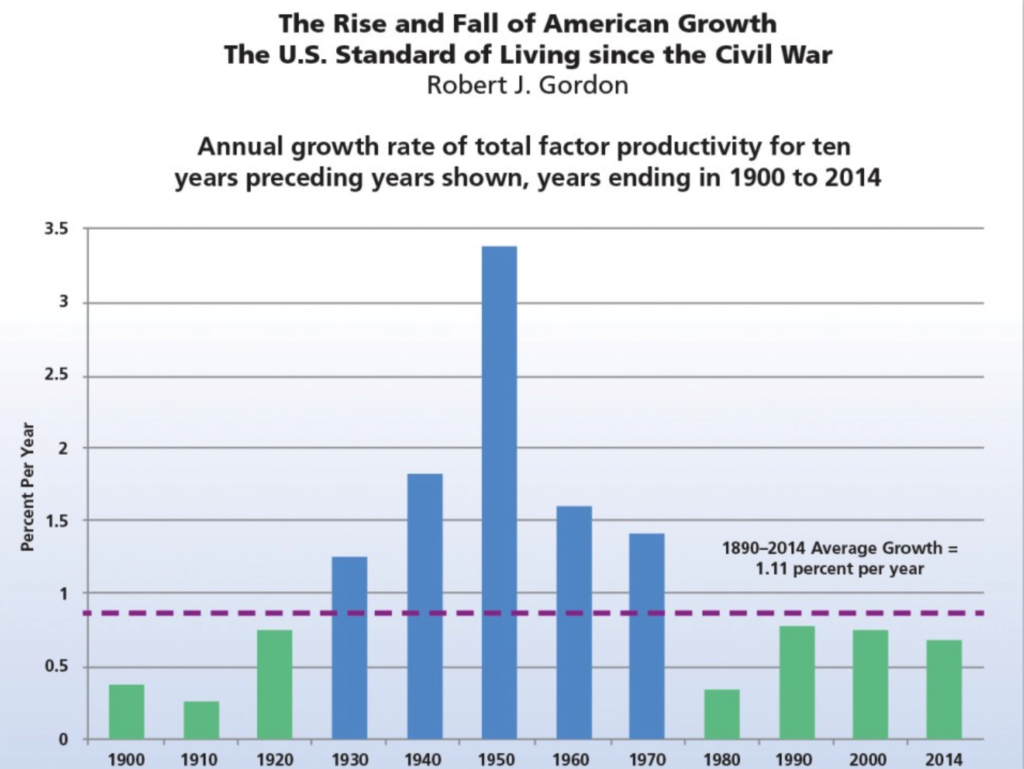

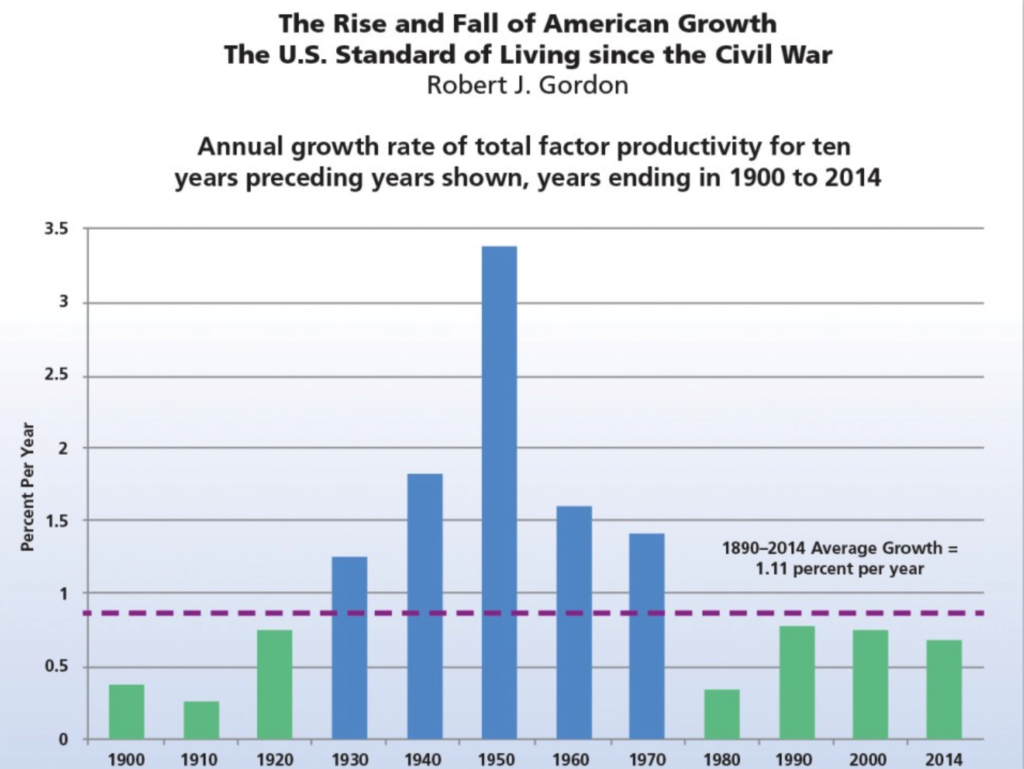

Aber ich möchte hier zunächst eine historische und sehr gründliche Beschäftigung mit dem Thema Wachstum und dessen Ausbleiben anführen, das in den letzten Jahren Furore gemacht hat: Robert J. Gordons „The Rise and Fall of American Growth“. In dieser umfangreichen, wie detaillierten wirtschaftshistorischen Studie weist Gorden nach, dass die goldenen Jahre des großen Wirtschaftswachstums in den USA lediglich eine Anomalie in der Geschichte war. Es waren wirklich nur die 100 Jahre vom Ende des Bürgerkriegs bis etwa 1970, in denen die Wirtschaft zweistellig wuchs und sich das Leben der Amerikaner gleichzeitig sichtbar und radikal zum besseren veränderte. Letzteres zeigt er nicht nur anhand der Wirtschaftsdaten, sondern steigt herab in die Haushalte und Betriebe jener Zeit und führt anschaulich auf, wie grundlegend sich das das Leben und Arbeiten in diesen hundert Jahren verändert hat: Elektrizität, künstliches Licht, der Telegraf, die Automobilität, die Waschmaschine – all diese Technologien haben das Leben der Menschen radikal auf den Kopf gestellt und Werte geschaffen, die auf einer breiten Front bei den Leuten ankamen.

Gordons These ist nun, dass dieser breite Wohlstandszuwachs von tatsächlicher Innovation angetrieben war und folglich unsere heutige Zeit – trotz all ihrer digitalen Zukunftsversprechungen – auf der Stelle tritt. Wirtschafts-theoretisch untermauert er diesen Befund, indem er sich eine Ableitung des Wirtschaftswachstums anschaut: die „Total Factor Productivity“. Diese Kennzahl normalisiert das Wachstum entlang der in ihr eingeflossenen Faktoren, nämlich Kapital und Arbeit. Rechnet man also den Mehreinsatz von Kapital und Arbeit aus dem Wachstum heraus, bekommt man den Anteil der Wertschöpfung, der weder durch Kapital noch Arbeit erklärbar ist: Diese Total Factor Productivity (TFP) sei laut Gordon eben der messbare Effekt von Innovation im Wachstum.

ABB 5. Aus The Rise and Fall of American Growth

ABB 5. Aus The Rise and Fall of American Growth

Da diese TFP über zwischen 1930 und 1970 stetig weit über einem Prozent war, davor oder danach aber wesentlich darunter, schließ Gordon daraus, dass trotz der großen Verwerfungen der Digitalisierung, diese kaum zu Innovation geführt habe. Gordon greift damit eine Beobachtung auf, die bereits Robert Solow 1987 gemacht hat: „You can see the computer age everywhere but in the productivity statistics.“ Auch der bekannte Silicon Valley Investor Peter Thiel beklagt in seinem Buch „Zero to One“, dass das Problem unserer Zeit sei, dass wir keine wirkliche Innovation mehr produzieren. Er unterscheidet zwischen Erfindungen, die aus dem Nichts zu etwas ganz Neuem führen (zero to one) und jenen, die eine vorhandene Erfindung lediglich weiteren Nutzer/innen zugänglich machen (One to N). Unsere heutige Zeit sei vor allem durch letzteres geprägt, lamentiert Thiel.

Ich möchte diesen Thesen widersprechen und eine gegenteilige These aufstellen: Ich glaube, dass es digitale Innovation gibt, dass sie real ist und tatsächlich unser aller Leben verändert, aber dass diese Innovation und Veränderung unseres Lebens mit herkömmlichen Maßstäben kaum zu messen ist. Um das zu erklären müssen wir schauen, wie solche Messungen, also solche Kennzahlen wie das Bruttoinlandsprodukt (im englischen GDP) und alle davon abgeleiteten Werte wie Wachstum, Produktivität oder eben TFP herkommen: Es wird geschaut, was in den unterschiedlichen Branchen an Geld umgesetzt wird, wie viel von was gekauft wird und am ende wird all das schlicht in eine Zahl zusammengerechnet. Kurz: Beim GDP handelt es sich um aufaddierte Transaktionen, was heißt: alles, was keine Transaktion verursacht, fließt nicht in die Rechnung ein.

Nun gibt es aber viele Gründe, warum sich gerade digitale Innovation oft transaktionsneutral oder gar transaktionsmindernd in den Zahlen niederschlägt:

- Durch das Internet wird die Markttransparenz erhöht. Wer kauft noch Dinge zu denen er/sie nicht vorher Produktreviews gelesen hat, dessen Händler keine gute Bewertung hat oder isst in einem Restaurant, das nicht irgendwo empfohlen wurde? Unsere Konsumentscheidungen sind heute viel fundierter als vor dem Internet, was aber auch bedeutet, dass wir weniger Fehlinvestitionen tätigen. Fehlinvestitionen sind aber oft zusätzliche Investitionen, die heute schlicht nicht mehr stattfinden.

- Der bereits anfangs erwähnte Spill-Over-Effekt hat dazu geführt, dass wir heute ein weitaus größeres kulturelles Angebot zur Verfügung haben, ohne wesentlich mehr Geld auszugeben. Dafür müssen wir nicht alle bei Bittorrent unsere Serien laden, aber allein, dass wir es könnten, zwingt die Anbieter attraktive Bezahlangebote zu schaffen. Verwertungs-Lobbyisten sprechen hier von einem „Value-Gap“, also dass es eine Lücke gibt, zwischen dem, was ein Kulturprodukt „wert“ wäre und dem, was tatsächlich dafür verlangt werden kann, ohne dass Leute zur illegalen Alternative greifen. Dieser Value-Gap ist ebenfalls ein Minus in der Wachstumsbilanz – allerdings in Form einer Konsumentenrente.

- Natürlich darf man nicht vergessen, auf wieviel kostenloses Wissen wir heute Zugriff haben. Allein die Wikipedia hat unsere ganze Art zu leben und zu arbeiten revolutioniert. Ich persönlich wüsste nicht mehr, wie ich mir sonst einen Einstieg in ein Thema verschaffen sollte. Die Wikipedia ist – bis auf ein paar wenige Spendenzahlungen – komplett kostenlos. Netto geht sie sogar mit einem satten Minus in die volkswirtschaftliche Gesamtrechnung ein, wenn man die vielen wegen ihr eingestampften Lexikonverlage gegenrechnet. Obwohl es vielfach versucht wurde, gibt keine sinnvolle Art den Wert der Wikipedia zu messen.

- Einen ähnlichen Effekt haben wir durch die Verwendung von Open Source Software in der Wirtschaft. Obwohl auf den meisten Büroschreibtischen nachwievor ein Microsoft Windowsrechner steht, läuft im Hintergrund der Großteil der weltweiten Serverinfrastruktur auf Linux und anderen Open Source Systemen. Diese Systeme kosten meistens keine Lizenzgebühren und werden kostenlos aus dem Netz kopiert. Es gibt natürlich kommerzielle Anbieter, die Softwarepakete schnüren und Support leisten, aber ihre Wirtschaftsleistung fällt gegenüber der substituierten Software kaum ins Gewicht. Natürlich hat auch das einen Value Gap Effekt auf den Windowspreis und unter anderem deswegen kann Apple seinen Nutzer/innen kein Geld mehr für neue Betriebssysteme oder Updates aus der Tasche pressen.

- Insgesamt werden alle möglichen Prozesse innerhalb der Wirtschaft durch Technologie immer effizienter gestaltet. Der Einzug von KI und und Big-Data wird immer wieder mit erheblichen Einsparungen beworben. Einsparungen sind aber nicht getätigte Transaktionen. Es sind Verschlankungen der Bilanz, denen zumindest nicht zwingend eine zusätzliche Investition gegenübersteht.

Zusammengefasst lautet die These: Digitale Innovationen spart mehr Transaktionen ein, als sie zusätzlich erschafft und das ist gut so. Oder radikaler: Wirtschaftswachstum und Nutzen verhalten sich in der digitalen Wirtschaft negativ proportional zueinander.

Angesichts dieser doch sehr radikal anderen Lage, stellt sich die Frage nach der säkularen Stagnation ganz anders: Warum haben wir überhaupt noch Wachstum?

Meine These dazu: Wir befinden uns in einer Blase, ähnlich wie 2007, aber mit immateriellen Werten. Ich nenne sie die „Intangible Bubble“. Ich glaube, Immaterialgüter sind massiv überbewertet. Sie sind überbewertet, weil sie künstlich am Spill-Over gehindert werden, der im Digitalen eigentlich der Naturzustand jeder Information ist. Plattform-Kontrolle, drakonische Urheberrechts-Gesetzgebung und -Durchsetzung haben zu einer künstlichen Verknappung von Ideen, Gedanken und kreativen Leistungen geführt, die auf der einen Seite unser aller Leben verarmt, um es uns auf der anderen wieder teuer verkaufen zu können.

Nimmt man diese These zur Grundlage, dann ist ein wesentlicher Teil des digitalen Wachstums der letzten Jahre einzig und allein durch das Aufbauen von größeren und besseren Kontrollstrukturen erwirtschaftet worden. Der Wertschöpfungsprozess ist unter den digitalen Bedingungen zum toxischischen “Rent Seeking” qua monopolartiger Kontrollstrukturen geworden. Jeder zusätzlich ausgegebene Euro stiftet keinen Nutzen mehr, sondern ist Ergebnis einer Nutzenseinschränkung und Minderung Wohlfahrt der Gesellschaft.

Das wäre die fünfte und letzte Frage an den digitalen Kapitalismus:

“Ist ein digitaler Kapitalismus mit nur noch behaupteten Kapital und überflüssiger Arbeit, der nicht mehr durch den Markt gesteuert wird, die Eigentumsordnung hinter sich gelassen hat und dessen kaum noch vorhandenes Wachstum aus der künstlichen Verknappung von Immaterialgütern resultiert, noch Kapitalismus?”

Fazit

Um das hier umstandslos zu formulieren: Nein, nein, das ist nicht mehr der Kapitalismus. Alle definitorischen Kriterien des Kapitalismus werden durch die digitale Wirtschaft ad absurdum geführt. Doch es bleiben Fragen:

Schock, schwere Not! Haben wir dann jetzt den Kommunismus oder was?

Natürlich ist das ebenfalls nicht der Fall. Zunächst stehen wir mit mindestens einem Bein ja noch voll und ganz im guten, alten analogen Kapitalismus. Und was das digitale Bein betrifft: Wir haben Kapitalismus immer nur in Abgrenzung zu Kommunismus oder Sozialismus – bestenfalls noch Anarchismus oder Feudalismus zu verstehen gelernt. Das, was die Digitalwirtschaft dort tut, ist keines von dem. Nicht alles, was nicht Kapitalismus ist, fällt automatisch in eine der anderen Kategorien.

Wir müssen an dieser Stelle der Neuheit der Situation gerecht werden. Dies ist unser aller erste Digitalisierung und somit sollten wir der Möglichkeit Rechnung tragen, dass es sich hier auch um eine komplett neue Form der Ökonomie handelt. Eine, für die wir noch keinen Namen haben und noch gar nicht wissen, wie sie funktioniert. Etwas, das noch im Werden ist. Dieses Etwas ist nicht automatisch besser oder schlechter, als der Kapitalismus, nur eben hinreichend anders. „Die alte Welt liegt im Sterben, die neue ist noch nicht geboren: Es ist die Zeit der Monster.“ soll Gramsci einmal gesagt haben. Wir haben es hier mit einem Monster zu tun, einem (noch) namenlosen Wesen. Monster sind nicht automatisch böse, aber sie machen uns Angst, weil wir sie nicht verstehen.

Doch warum riecht dieses Monster so sehr nach Kapitalismus, schmeckt wie Kapitalismus und sieht zumindest mit zugekniffenen Augen aus wie Kapitalismus?

Auch wenn unter der Haube kein kapitalistischer Motor mehr seine Arbeit verrichtet, ahmt seine Hülle den Kapitalismus doch irgendwie nach. Nicht in Täuschungsabsicht, sondern weil es nichts anderes kennt. Es ist derselbe Grund, wieso das Fernsehen zuerst Theaterstücke zeigte und wieso das erste Automobil zunächst nicht aussah wie ein Automobil, sondern wie eine Kutsche. Woher sollte Karl Benz schließlich wissen, wie ein Automobil aussieht? Er hatte noch keines gesehen.

ABB 6. Der erste Benz

ABB 6. Der erste Benz

Gut. Und was tun wir jetzt mit dieser Erkenntnis?

Wir wissen an dieser Stelle schon genug, um ein paar Dinge festzuhalten: Der Kapitalismus und die digitale Ökonomie unterscheiden sich ganz wesentlich und zwar vor allem auch darin, was Wachstum in beiden Systemen bedeutet.

Wachstum bedeutete einst, dass mehr Menschen, mehr Dinge tun können. Dass Produkte billiger wurden, mehr Menschen Zugang zu fließend Wasser, Strom, ein Auto, ein Eigenheim bekamen. Sie konsumierten mehr und es ging vielen Leuten deutlich besser. Wachstum war etwas gutes.

In der digitalen Ökonomie bedeutet Wachstum, dass die Kosumentenrente erfolgreicher abgeschöpft wird, dass also mehr Menschen unnötigerweise mehr bezahlt haben, als sie unter normalen Marktbedingungen müssten. Wachstum bedeutet, dass immaterielle Güter erfolgreicher verknappt wurden, dass also Menschen erfolgreich davon abgehalten wurden, an Ideen und Erfindungen zu partizipieren, obwohl es niemanden etwas kosten würde, wenn sie es täten. Wachstum bedeutet außerdem, dass noch mehr Bullshitjobs geschaffen werden, um die Leute ruhig zu halten. Es bedeutet die Ausweitung von Kontroll- und Überwachungsstrukturen und natürlich bedeutet es heute auch den unnötigen Verbrauch von Ressourcen in Zeiten des Klimawandels.

Kurz: Wachstum bedeutet nichts gutes in der digitalen Ökonomie. Der Nutzen von Wachstum ist negativ und mindert die Wohlfahrt der Gesellschaft. Diese Erkenntnis sollte unser ganzes politisch-ökonomisches Denken umstellen. Wir sollten also aufhören, Wachstum als Ziel zu setzen und wir sollten Politiker/innen ausbuhen, die uns Wachstum versprechen.

“Digital Degrowth” wäre nicht wie die ökologische Degrowth-Bewegung eine Verzichts- und Selbstgeißelungs-Religion oder eine aus der Not heraus geforderte Zurückhaltung, sondern ein Programm von dem alle profitieren. „Lasst uns das Bruttoinlandsprodukt senken und so die Konsumentenrente hochdrehen, damit alle was davon haben!“

Konkreter: Die Netz-Bewegung hat die Frage nach den Immaterialgüterrechten über Jahre sträflich vernachlässigt. Obwohl die Reform der Immaterialgüter für die digitale Welt gewissermaßen die Gründungsidee des Netzaktivismus war, kämpfte er die letzten Jahre nur mehr Rückzugskämpfe bei dem Thema. Wir haben uns einreden lassen, dass es bei Urheberrechtsdiskussionen ja nur um die Beschaffungskriminalität von jugendlichen Musik- und Film-Konsument/innen ging. Doch Immaterialgüter sind die neuen Produktionsmittel und ihre Ungleichverteilung wird heute nur durch enormen Kontrollaufwand bewerkstelligt. Die Vergesellschaftung der Produktionsmittel, wie Marx sie gefordert hat, ist angesichts dieser Situation die selbstverständliche Folgerung.

Netzaktivist/innen streiten reflexhaft ab, wenn Rechteverwerter ihnen vorwerfen, sie wollten das Urheberrecht abschaffen. Warum eigentlich? Ja, wir sollten noch viel entschiedener und radikaler kämpfen, für Open Data, Open Access, Open Source, aber auch für Plattformen wie Sci-Hub, Bittorrent sowie für eine radikale Patentreform und die letztendliche Abschaffung des Urheberrechts.

Happy Spill Over!

Es war im Jahr 1957, als ein Amerikaner namens James Vicary herausfand, dass man Menschen mittels bewusst kaum wahrnehmbarer Botschaften manipulieren kann. Blendet man zum Beispiel im Kino für den Bruchteil einer Sekunde die Botschaft „Esst mehr Popcorn“ ein, steigt nachweisbar der Popcorn-Umsatz. Vicarys Studie zu „Sublimnal Stimuli“ wurde weltberühmt. Allerdings nicht durch Vicary selbst, sondern über ein Buch, das im selben Jahr Furore machte: „Die Geheimen Verführer“ von Vance Packard.

Es war im Jahr 1957, als ein Amerikaner namens James Vicary herausfand, dass man Menschen mittels bewusst kaum wahrnehmbarer Botschaften manipulieren kann. Blendet man zum Beispiel im Kino für den Bruchteil einer Sekunde die Botschaft „Esst mehr Popcorn“ ein, steigt nachweisbar der Popcorn-Umsatz. Vicarys Studie zu „Sublimnal Stimuli“ wurde weltberühmt. Allerdings nicht durch Vicary selbst, sondern über ein Buch, das im selben Jahr Furore machte: „Die Geheimen Verführer“ von Vance Packard. ABB. 1 Aus Capitalism without Capital

ABB. 1 Aus Capitalism without Capital ABB 2. Aus International Labour Organization Organisation for Economic Co-operation and Development, The Labour Share in G20 Economies

ABB 2. Aus International Labour Organization Organisation for Economic Co-operation and Development, The Labour Share in G20 Economies ABB 3. Nachfragekurve und Konsumentenrente

ABB 3. Nachfragekurve und Konsumentenrente ABB 4. Besitz vs. Eigentum

ABB 4. Besitz vs. Eigentum ABB 5. Aus The Rise and Fall of American Growth

ABB 5. Aus The Rise and Fall of American Growth ABB 6. Der erste Benz

ABB 6. Der erste Benz